深度解析ETL:定義、功能、工作流程與工具

作者: 數環通發布時間: 2024-10-24 13:41:49

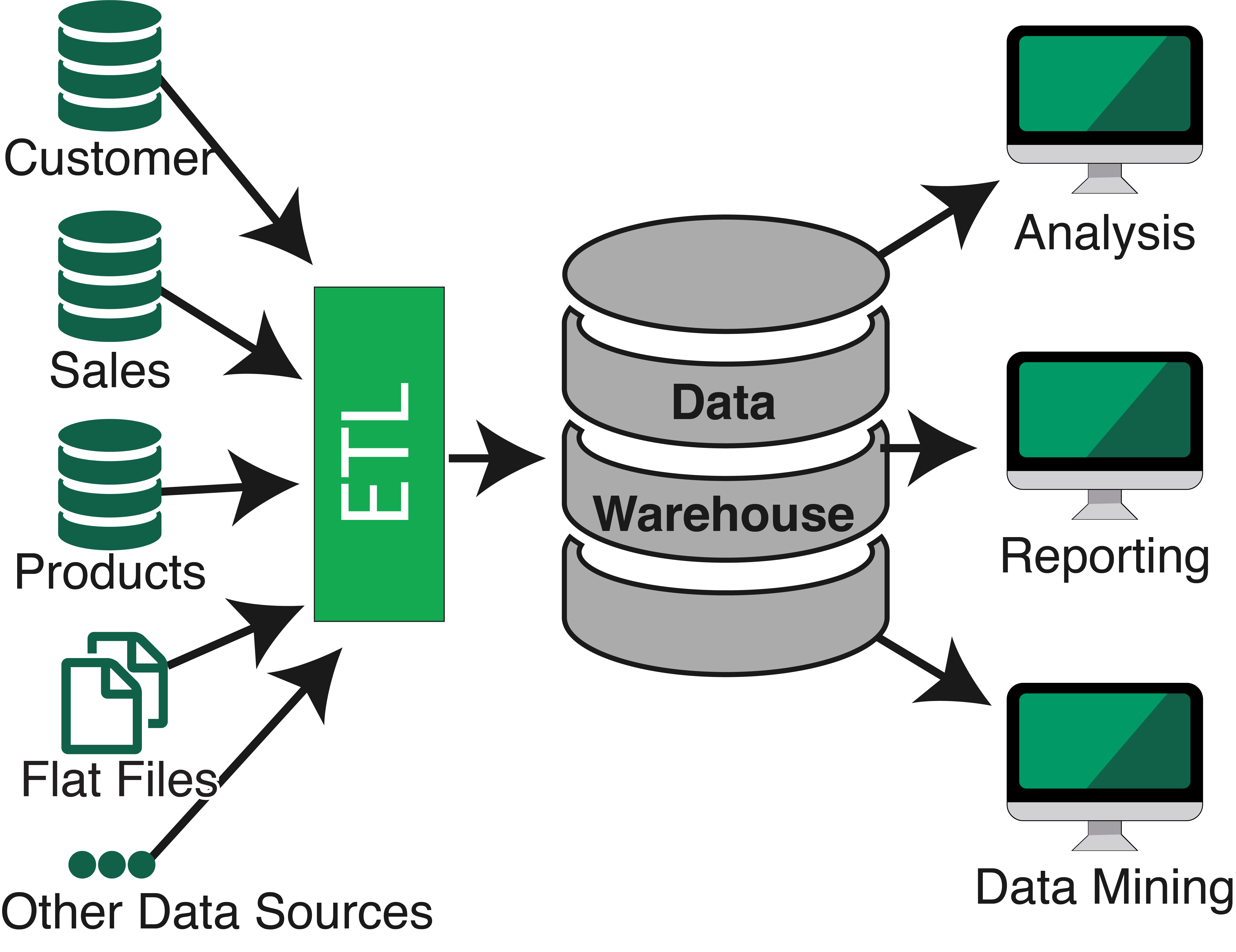

ETL是一種數據集成的過程,涉及從各種數據源提取數據、轉換數據以滿足目標系統的要求,并將數據加載到目標數據庫或數據倉庫中。ETL是數據倉庫的生命線,對于企業或行業應用來說,ETL工具是處理、轉換、遷移數據的重要工具。

一、ETL的定義

ETL是Extract、Transform、Load的縮寫,分別代表提取、轉換和加載三個步驟。它是一種常用的數據集成方法,它是企業數據倉庫(EDW)和數據集成中的重要組成部分,旨在將分散、零亂、標準不統一的數據整合為一致、可用的數據,以支持企業的決策和分析。

二、ETL的主要作用

數據來源分散:ETL幫助組織將分散在不同應用程序和系統中的數據整合在一起,使其更易于訪問和使用。

數據質量低:ETL通過清洗、轉換和標準化數據來提高數據質量。

數據處理效率低:ETL自動化數據整合過程,提高數據處理效率。

數據統一性:ETL實現數據的一致性,對于組織的數據來說至關重要。

數據分析:ETL整合并轉換數據,為數據分析提供準備。

三、ETL的詳細流程

數據提取(Extract)

-數據源:ETL可以從多種數據源中提取數據,包括關系數據庫、非關系數據庫、文件系統、Web服務、消息隊列等。

-提取方式:數據提取可以使用各種技術,如數據庫查詢、文件讀取、API調用等。提取的數據可以是結構化的(如表格數據)或非結構化的(如文本、圖像等)。

數據轉換(Transform)

-數據清洗:修正、刪除、填充等操作,以消除數據中的錯誤、缺失或重復項。

-數據規范化:將數據轉換為一致的格式和結構,便于比較和分析。

-數據合并:將來自不同源的數據合并在一起,創建一個全面的、一致的數據集。

-數據拆分:將單個字段中的數據拆分成多個字段,便于比較和分析。

-數據轉換:對數據進行計算、格式化、轉換等操作,便于比較和分析。

-數據聚合:對數據進行匯總、分組等操作,便于比較和分析。

-數據標準化:將數據轉換為一致的標準,便于比較和分析。

數據加載(Load)

-加載方式:將經過轉換的數據加載到目標數據庫或數據倉庫中。加載的方式可以是全量加載(一次性加載所有數據)或增量加載(只加載新增或更新的數據)。

-加載要求:在加載過程中需要考慮數據的一致性和完整性,確保數據的正確性和可靠性。

四、ETL的優化策略

源數據優化:在ETL之前,可以對源數據進行優化以提高ETL過程的性能。例如,使用索引來加速數據庫查詢,或使用壓縮來減少數據傳輸的時間和帶寬占用。

轉換操作優化:在ETL的轉換操作中,可以采用各種技術來優化性能。例如,使用內存表而不是磁盤表來提高查詢速度,或使用批量操作而不是逐行操作來減少處理時間。

并行處理:將ETL過程分解成多個任務并行執行,可以提高處理效率。例如,使用多個線程或多個節點并行處理數據,以縮短處理時間。

分區處理:對大型數據集進行分區處理,可以提高ETL過程的性能。例如,將大型數據集拆分成多個子集,然后在不同的節點或線程中并行處理。

五、ETL工具

ETL過程通常使用專門的ETL工具來執行,這些工具提供了圖形化界面和自動化功能,簡化了ETL流程的管理和維護。常見的ETL工具包括Kettle、Talend、DataPipeline、DataX和Oracle Goldengate等。這些工具通常具有數據抽取、轉換、加載以及日志記錄等功能,并支持多種數據源和目標系統的連接。

六、ETL的應用場景

數據倉庫構建:ETL是構建和維護數據倉庫的重要環節,通過ETL過程可以將來自不同數據源的數據整合到一個統一的數據倉庫中。

數據同步和遷移:ETL可以用于數據同步和遷移,將舊系統中的數據遷移到新系統中,保持數據的連續性和一致性。

數據分析:通過ETL過程整合的數據可以為企業的數據分析提供支持,幫助企業做出更明智的決策。

綜上所述,ETL是一種重要的數據集成和處理過程,它通過提取、轉換和加載三個步驟將不同數據源的數據整合到一起,為企業的分析決策提供有質量保證的數據源。同時,ETL過程還可以通過優化策略和專門工具來提高性能和效率。

更多關于ETL內容

>>>ETL vs ELT:全面解析數據集成方法的選擇與應用