數據湖集成:構建企業智能數據生態的關鍵路徑

在當今數字化時代,數據已成為企業最為寶貴的資產之一。如何高效地存儲、管理和利用海量的多類型數據,成為企業在激烈競爭中脫穎而出的關鍵。數據湖作為一種創新的數據存儲與管理范式,正逐漸成為企業實現數據價值最大化的核心技術。而數據湖集成,則更是將這一潛力充分釋放的關鍵所在。

一、數據湖集成的核心內涵與技術架構

數據湖的本質與價值

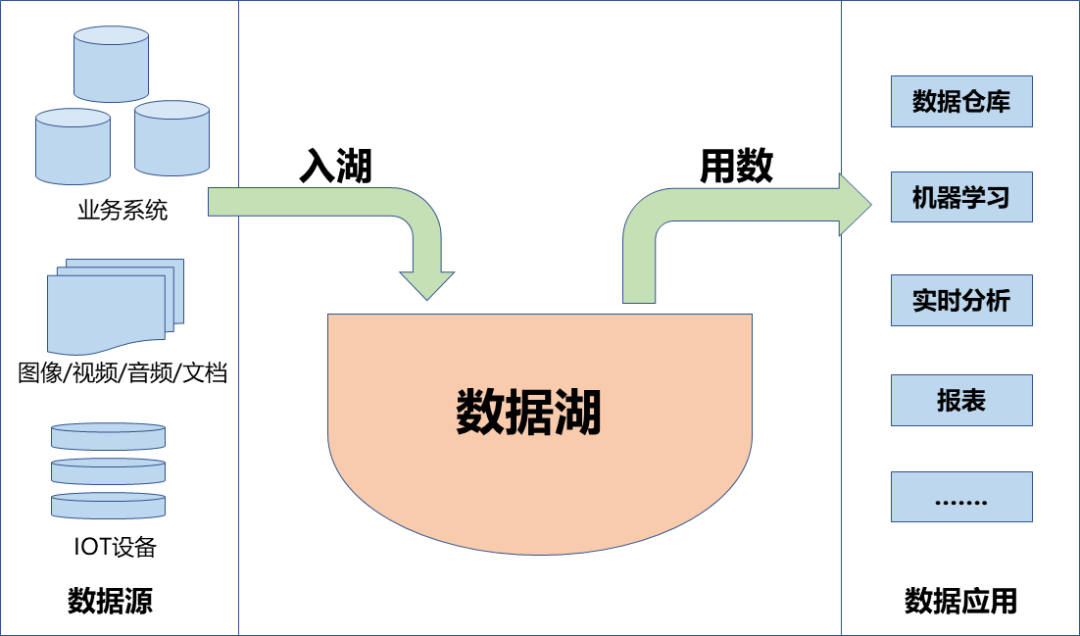

數據湖(Data Lake)是一種以原始格式存儲海量多類型數據的集中式存儲系統。與傳統數據倉庫不同,它打破了格式的限制,能夠支持結構化、半結構化和非結構化數據的統一存儲與管理。這種靈活性使得企業可以存儲所有類型的數據,無需事先對數據進行結構化處理,為后續的深度分析和創新應用提供了豐富的素材。例如,企業可以將來自數據庫的結構化交易數據、日志文件中的非結構化記錄以及 IoT 設備產生的半結構化傳感器數據,全部存儲在數據湖中,為全面洞察業務提供了可能。

技術架構的演進歷程

傳統數據湖架構以 Hadoop 生態為核心,HDFS 分布式存儲為數據存儲提供了基礎,MapReduce 則用于批量處理數據。然而,這種架構存在著明顯的局限性,如實時性不足,難以滿足對數據實時響應的業務需求;治理能力薄弱,在面對大規模、復雜的數據時,難以實現有效的數據管理。

隨著技術的不斷發展,新一代數據湖集成架構應運而生。它融合了云原生技術(如對象存儲)、流式計算引擎(如 Apache Kafka、Flink)及智能元數據管理工具。以 Azure Data Lake 為例,它通過集成 Spark、U - SQL 及實時分析服務,實現了從 PB 級數據存儲到交互式查詢的全流程處理。用戶可以在海量數據上進行實時分析,快速獲取有價值的信息。Solix 推出的第三代數據湖平臺,則通過統一的數據治理框架(如元數據管理、數據管道),創新性地實現了 “湖倉一體”。這種架構將數據倉庫的強大功能與數據湖的靈活性完美結合,為企業提供了更加高效的數據管理與分析解決方案。

核心組件與關鍵能力

數據連接與采集:強大的數據連接與采集能力是數據湖集成的基礎。Solix Connect 可連接超過 1000 種數據源,涵蓋了 Oracle、PostgreSQL 等常見數據庫,以及各類文件系統、消息隊列等。并且,通過低代碼工具,企業可以輕松實現異構數據的同步,大大降低了數據接入的難度和成本。這意味著企業能夠快速將分散在各個角落的數據匯聚到數據湖中,為后續的分析和應用做好準備。

元數據管理:元數據管理是數據湖集成的關鍵環節。通過自動化的數據分類、標簽化及血緣追蹤,能夠確保數據的可追溯性與一致性。華為數據湖解決方案的 “數據資產一張圖” 功能,通過構建全局元數據視圖,讓企業對數據資產一目了然。這不僅方便了數據的查找和使用,還提升了數據管理的效率,保障了數據質量。

計算與處理引擎:為滿足多樣化的分析需求,數據湖集成架構結合了多種計算與處理引擎。批處理(如 Spark)適用于大規模數據的離線處理,能夠高效地處理復雜的分析任務;流處理(如 Flink)則專注于實時數據處理,能夠對實時產生的數據進行快速分析和響應;機器學習框架(如 TensorFlow)的集成,使得企業可以在數據湖上進行人工智能模型的訓練和應用。百度智能云 EasyDAP 平臺通過集成 Spark 和實時流引擎,為企業級數據分析與開發提供了強大的支持,助力企業從數據中挖掘更多價值。

二、數據湖集成的實施策略與關鍵挑戰

實施策略

數據源分級管理:企業的數據源眾多且復雜,根據業務優先級對數據源進行分級管理至關重要。在金融行業,核心交易系統產生的數據具有高實時性和重要性,需要優先集成,以滿足實時風控等業務需求;而在制造業,設備傳感器數據雖然數據量龐大,但處理頻率可能相對較低,更適合進行批量處理。通過這種差異化的集成策略,企業能夠合理分配資源,確保關鍵業務數據的及時處理和應用。

分層架構設計:采用 “原始層 - 清洗層 - 應用層” 的分層模型是數據湖集成的有效架構設計。原始層保留全量原始數據,為后續的分析和回溯提供完整的數據基礎;清洗層通過 ETL 工具(如 Apache NiFi)對原始數據進行標準化處理,去除噪聲、填補缺失值、統一數據格式等,提升數據質量;應用層則根據不同的業務需求,構建數據集市或為 AI 模型訓練提供數據集。這種分層架構使得數據處理流程清晰,便于管理和維護。

數據質量管理:數據質量是數據湖集成的生命線。通過自動化規則(如字段校驗、空值填充)與人工審核相結合的方式,能夠有效提升數據可信度。微軟 Azure Data Lake 內置的數據治理模塊,支持動態質量監控與異常告警。企業可以設定數據質量規則,實時監測數據的質量情況,一旦發現異常,及時進行處理,確保數據的準確性和可用性。

關鍵挑戰與解決方案

技術復雜性:多技術棧的整合是數據湖集成面臨的一大挑戰。不同的技術組件之間可能存在兼容性問題,這會導致運維成本大幅上升。企業可以通過選擇一體化平臺(如華為數據湖解決方案),該平臺將多種技術組件進行了深度整合,提供了一站式的解決方案;或者采用云服務(如 AWS Lake Formation),云服務提供商負責底層技術的管理和維護,企業只需關注自身業務應用,從而降低技術門檻。

數據治理難題:數據沼澤化是數據湖建設過程中常見的問題,如果數據缺乏有效的治理,就會陷入混亂,難以被有效利用。通過元數據管理工具(如 Apache Atlas),可以對數據進行分類、描述和追蹤,讓數據變得有序;權限控制(如 RBAC)則確保只有授權人員能夠訪問和操作數據,保障數據安全。Solix 的數據治理組件提供聯合審計與生命周期管理功能,從數據的產生到消亡,全程進行管理和監督,確保數據的合規性。

成本優化:數據湖的存儲和計算資源需求往往較大,成本優化成為企業關注的重點。云原生架構支持按需擴展存儲與計算資源,企業可以根據實際業務需求靈活調整資源配置。Azure Data Lake 的獨立存儲與計算資源分離設計,使得企業可以分別對存儲和計算資源進行優化,顯著降低長期運維成本。在業務低谷期,可以減少計算資源的使用,而在業務高峰期,則靈活增加資源,避免資源浪費。

三、行業應用場景與實踐案例

金融行業:實時風控與客戶畫像

某銀行采用華為數據湖解決方案,對核心交易系統、用戶行為日志及外部征信數據進行集成。利用流式計算引擎(Flink)處理每秒數萬筆交易,結合機器學習算法,能夠快速識別異常模式。在實時反欺詐場景中,將風險響應時間縮短至毫秒級,有效保障了銀行的資金安全。同時,通過對多源數據的整合分析,構建了精準的客戶畫像,為個性化營銷和客戶服務提供了有力支持。

制造業:設備預測性維護

某汽車制造商借助百度 EasyDAP 平臺,集成生產線傳感器數據(半結構化日志)與 ERP 系統數據(結構化)。利用 Spark MLlib 訓練設備故障預測模型,通過對設備運行數據的實時監測和分析,提前預測設備故障,實現了備件庫存優化。通過這種方式,維護成本降低了 30%,提高了生產效率,減少了因設備故障導致的停機時間。

互聯網:用戶行為分析與推薦

某視頻平臺基于 Azure Data Lake 集成用戶點擊流、視頻元數據及第三方社交數據。通過交互式分析(Presto)與圖計算(GraphX),深入挖掘用戶行為模式,生成個性化推薦列表。這一舉措使得用戶留存率提升了 15%,增加了用戶粘性,為平臺帶來了更多的流量和商業機會。

四、未來趨勢與優化方向

智能化與自動化

AI 驅動的數據治理:隨著人工智能技術的發展,利用 NLP 技術自動生成數據標簽成為可能。Solix 的智能分類引擎能夠基于數據內容自動標記敏感數據,大大提升了元數據管理的效率。這意味著企業可以更加高效地對海量數據進行分類和管理,減少人工標注的工作量和錯誤率。

自動化管道編排:低代碼工具(如 Apache Airflow)結合 AI,能夠對 ETL 流程進行優化和自動化編排。通過智能算法,自動調整數據處理任務的順序和資源分配,減少人工干預,提高數據處理的效率和準確性。企業可以根據業務需求快速搭建和調整數據管道,實現數據的高效流轉和處理。

實時化與邊緣集成

邊緣數據湖:在 IoT 場景中,數據產生的速度和規模都非常巨大,將數據湖能力延伸至邊緣節點具有重要意義。華為全閃存新品支持邊緣端高吞吐數據寫入,能夠在本地實時處理數據,滿足工業物聯網低延遲的需求。例如,在工廠生產線上,通過邊緣數據湖對傳感器數據進行實時分析和處理,可以及時調整生產參數,提高生產質量和效率。

云原生與開放生態

多云協同:為了避免供應商鎖定,企業逐步采用跨云數據湖架構(如 Delta Lake)。這種架構能夠在多個云平臺之間實現數據的共享和協同,企業可以根據不同云平臺的優勢,靈活選擇和使用云服務。例如,在某些業務場景下,可以利用 AWS 的強大計算能力,同時借助 Azure 的數據存儲優勢,實現資源的最優配置。

開源生態融合:開源技術在數據湖領域發揮著越來越重要的作用。華為開源 open - GFS 引擎,加速了數據湖技術的普及。通過開源生態的融合,企業可以借鑒全球開發者的智慧和經驗,共同推動數據湖技術的發展和創新。同時,開源社區也為企業提供了豐富的技術資源和解決方案,降低了企業的技術研發成本。

五、結論

數據湖集成不僅是技術工具的升級,更是企業數據戰略的核心支柱。通過科學的架構設計、嚴格的數據治理及場景化應用,企業能夠將分散的數據資產轉化為驅動創新的核心資源。在金融、制造業、互聯網等各個行業,數據湖集成已經展現出了巨大的價值,幫助企業提升風險控制能力、優化生產流程、增強用戶體驗。未來,隨著 AI 與云原生技術的深度融合,數據湖集成將進一步向智能化、實時化方向演進,成為企業數字化轉型的基石。企業應積極擁抱這一技術趨勢,充分挖掘數據湖集成的潛力,在數字化時代的浪潮中搶占先機,實現可持續發展。